To download the app, visit: Library

:::Użyj LandingLens LandingAI do szybkiego wykrywania obiektów.

Cel

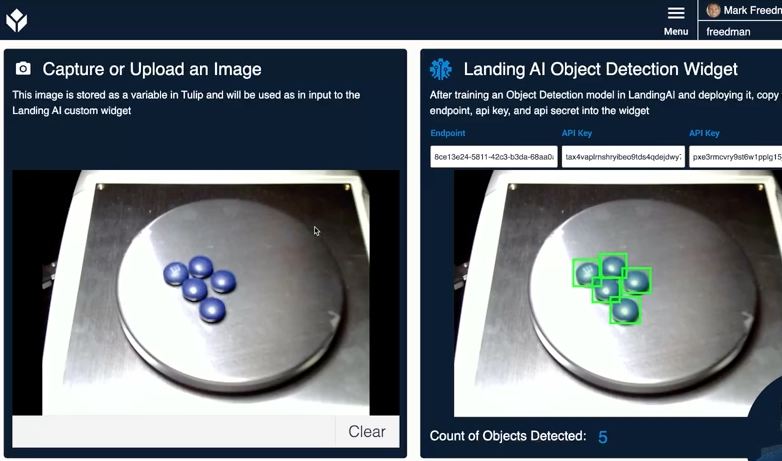

Ten widget umożliwia dostęp do modeli Vision / uczenia maszynowego, które zostały utworzone w LandingLens. Za pomocą tego widżetu możesz zrobić zdjęcie w Tulip i wysłać je do punktu końcowego LandingLens, zwracając liczbę obiektów znalezionych przez model AI.

Konfiguracja

Aby korzystać z tego widżetu, musisz mieć konto na https://landing.ai/{target="_blank"}. Pełna dokumentacja dotycząca działania platformy znajduje się w dokumentacji pomocy technicznej{target="_blank"}.

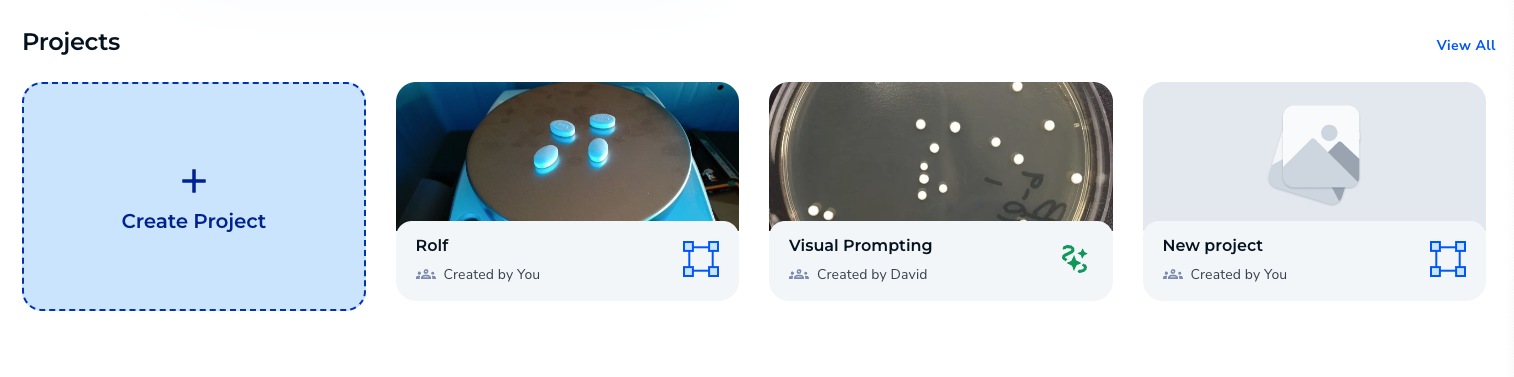

- Utwórz nowy projekt.

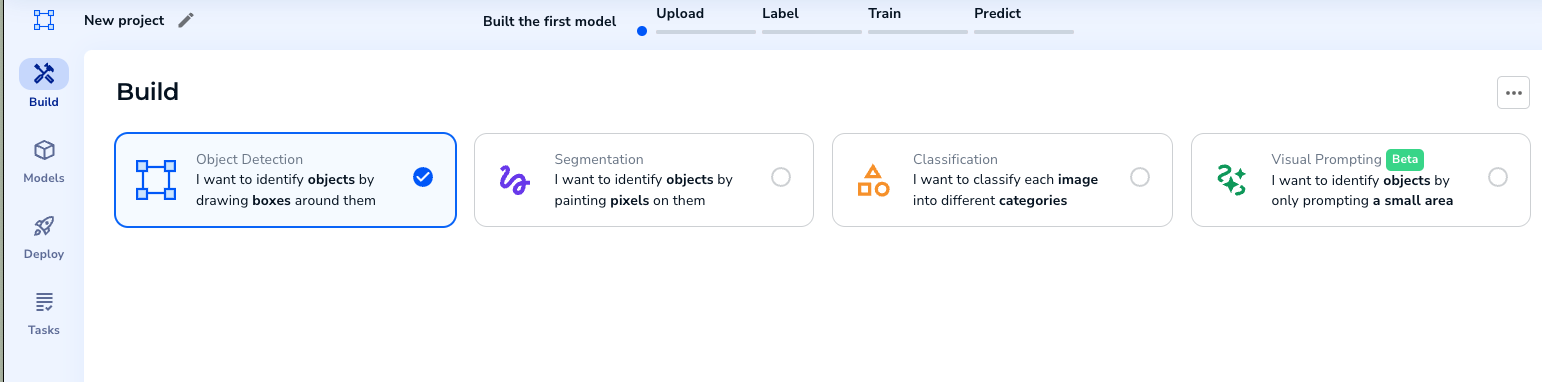

- Wybierz projekt wykrywania obiektów.

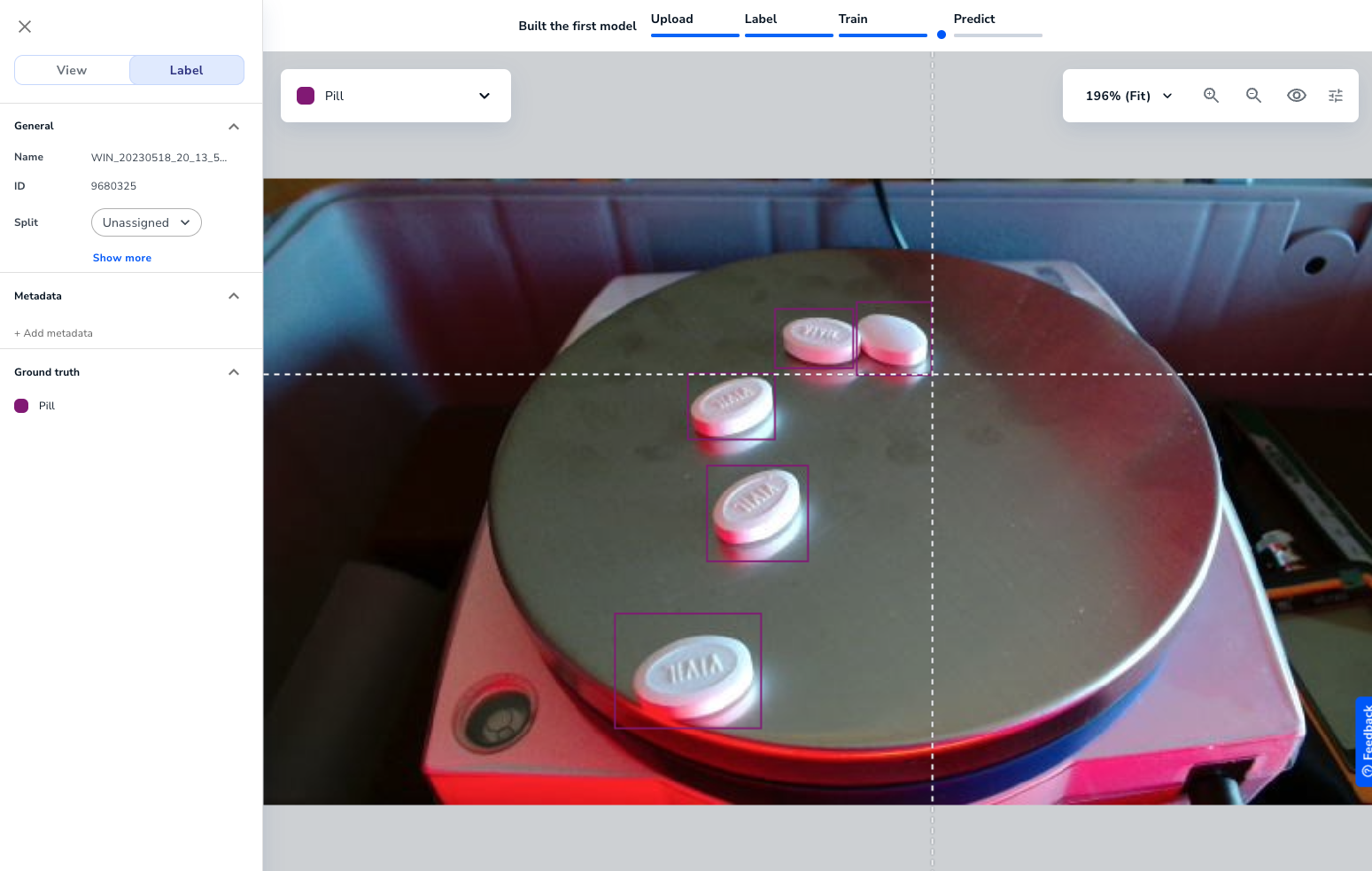

- Prześlij obrazy treningowe, potrzebujesz tylko 10. Następnie oznacz obrazy, identyfikując obiekty.

Po oznaczeniu wystarczającej liczby obrazów będziesz mógł wytrenować model.

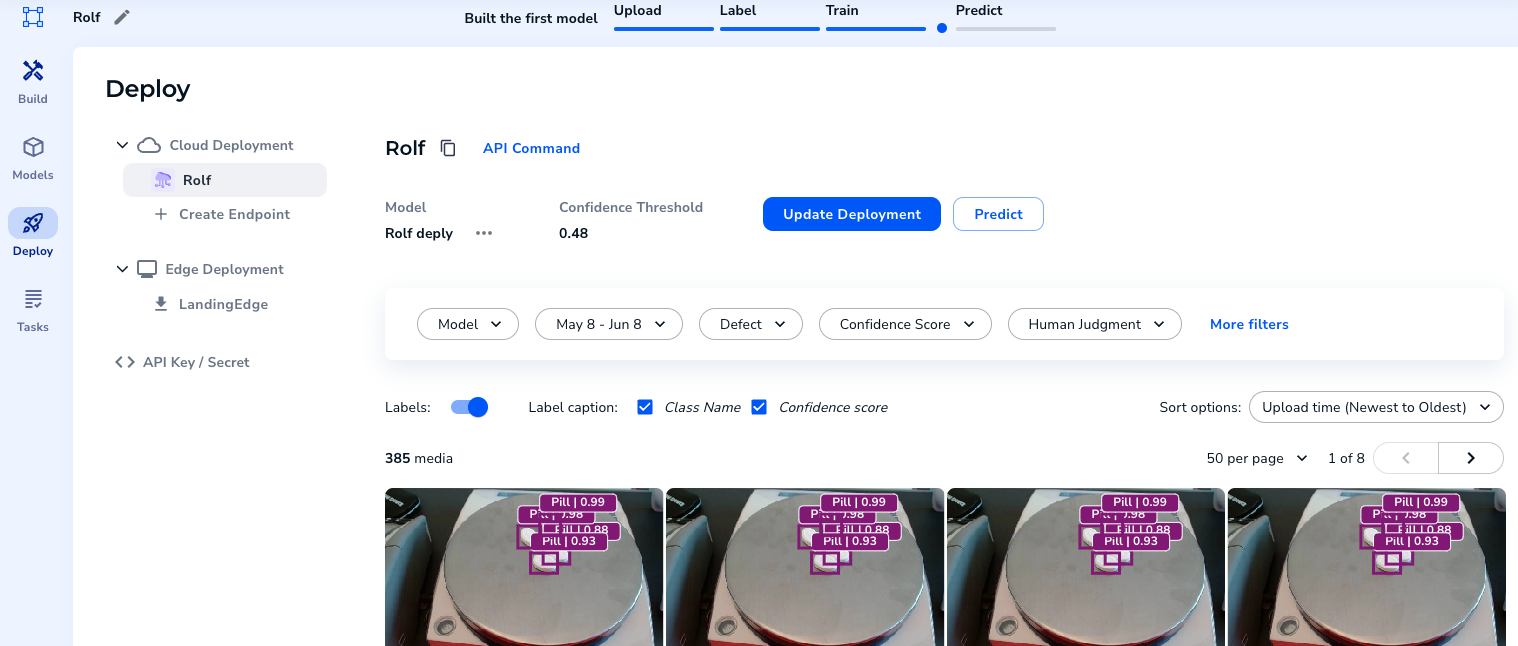

- Po wytrenowaniu modelu można go wdrożyć i utworzyć punkt końcowy.

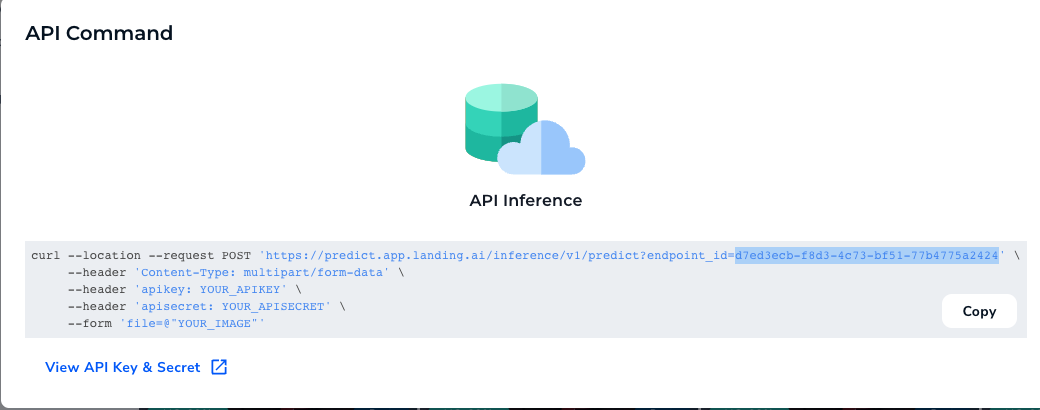

- Jeśli wybierzesz "API Command", będziesz mógł wyświetlić punkt końcowy

{height="" width=""}.

{height="" width=""}.

Skopiuj klucz API i sekret.

Jak to działa

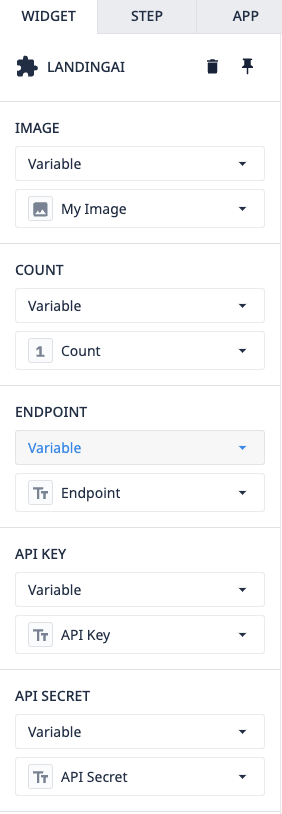

Sama aplikacja i widget są łatwe w użyciu. Widżet ma kilka wstępnie wypełnionych rekwizytów.

Image - Jest to obraz, który wyślesz do LandingLens z TulipCount - Ta zmienna jest zapisywana przez widget i reprezentuje liczbę obiektów wykrytych przez modelEndpoint - Jest to skopiowane/wklejone z twojego projektuAPIKey & Secret - Są to skopiowane/wklejone z twojego wdrożonego projektu.

Jeśli wszystkie te rekwizyty zostaną wypełnione, widżet wyśle żądanie do API LandingAI i zwróci obraz z zaznaczonymi obiektami