To download the app, visit: Library

:::랜딩AI의 랜딩렌즈를 사용하여 빠른 물체 감지를 수행합니다.

목적

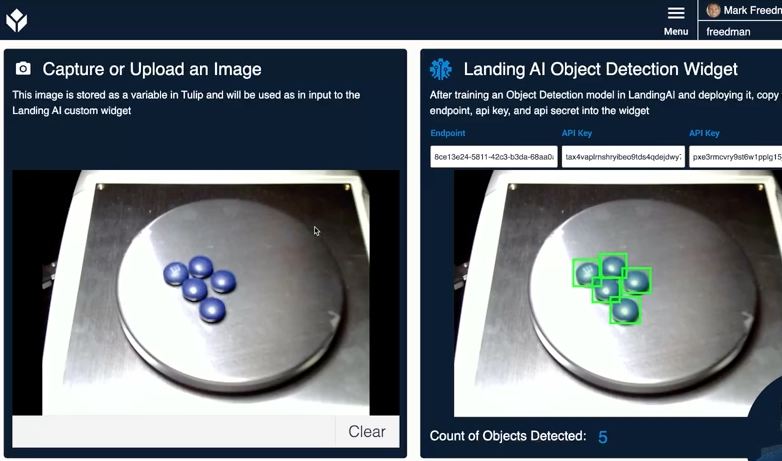

이 위젯을 사용하면 랜딩렌즈 내에서 생성한 비전/머신러닝 모델에 액세스할 수 있습니다. 이 위젯을 사용하면 Tulip에서 사진을 찍어 LandingLens 엔드포인트로 전송하여 AI 모델이 찾은 객체 수를 반환할 수 있습니다.

설정

이 위젯을 사용하려면 https://landing.ai/{target="_blank"} 계정이 필요합니다. 플랫폼 작동 방식에 대한 전체 문서는 해당 지원 문서{target="_blank"}를 참조하세요.

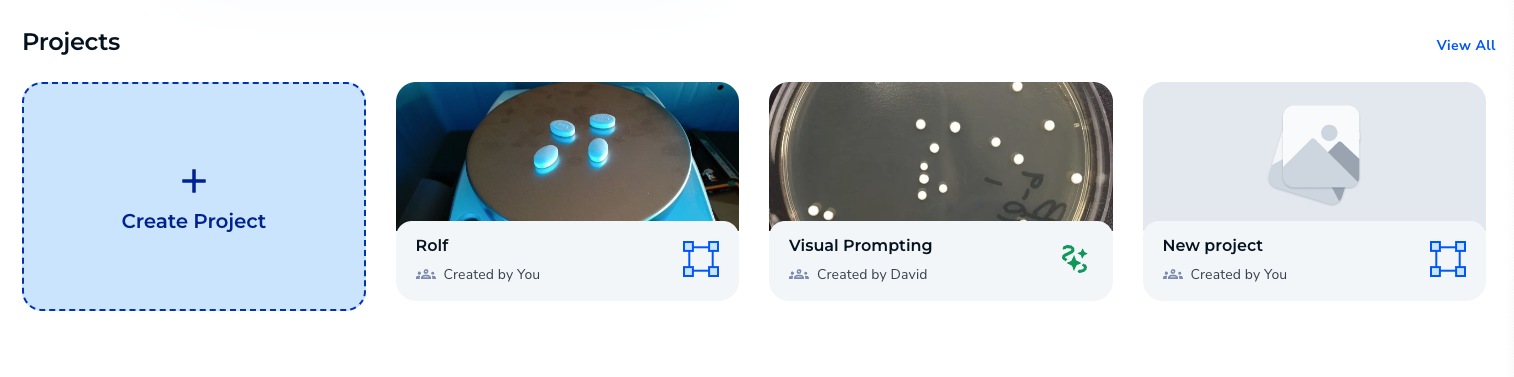

- 새 프로젝트를 만듭니다.

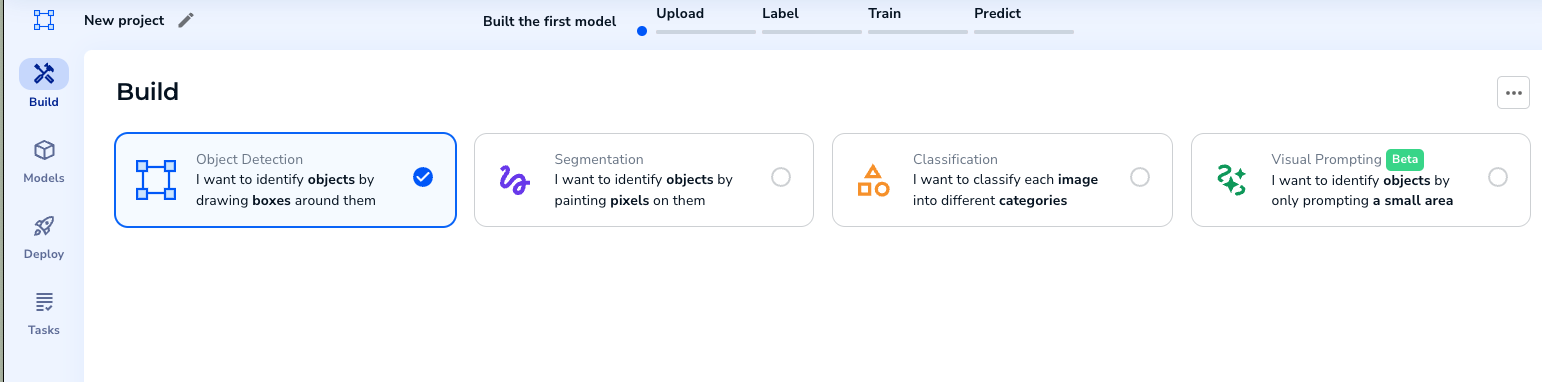

- 물체 감지 프로젝트를 선택합니다.

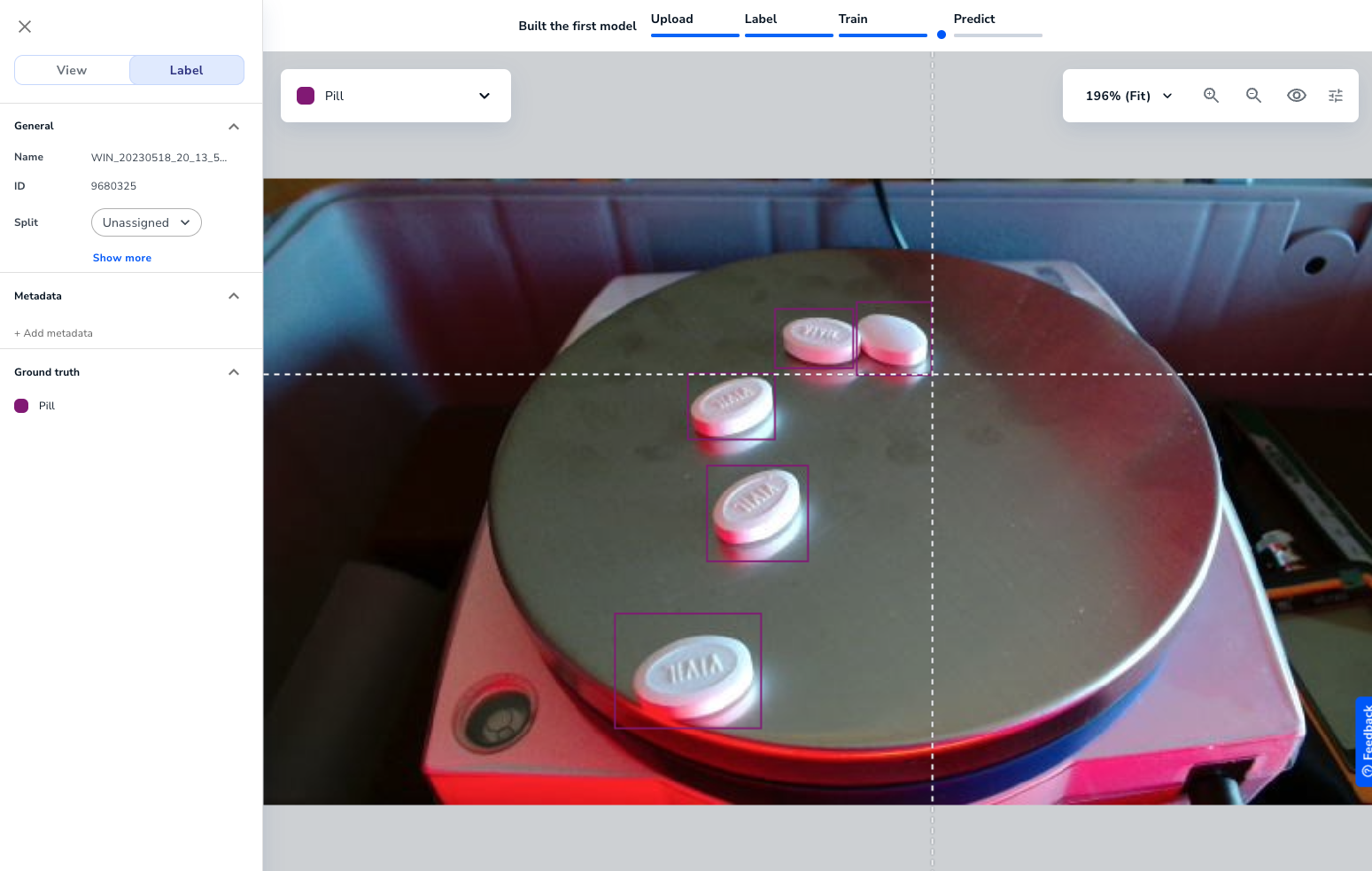

- 훈련 이미지를 업로드합니다. 10개만 필요합니다. 그런 다음 물체를 식별하는 이미지에 라벨을 붙입니다.

충분한 이미지에 라벨을 붙이면 모델을 학습시킬 수 있습니다.

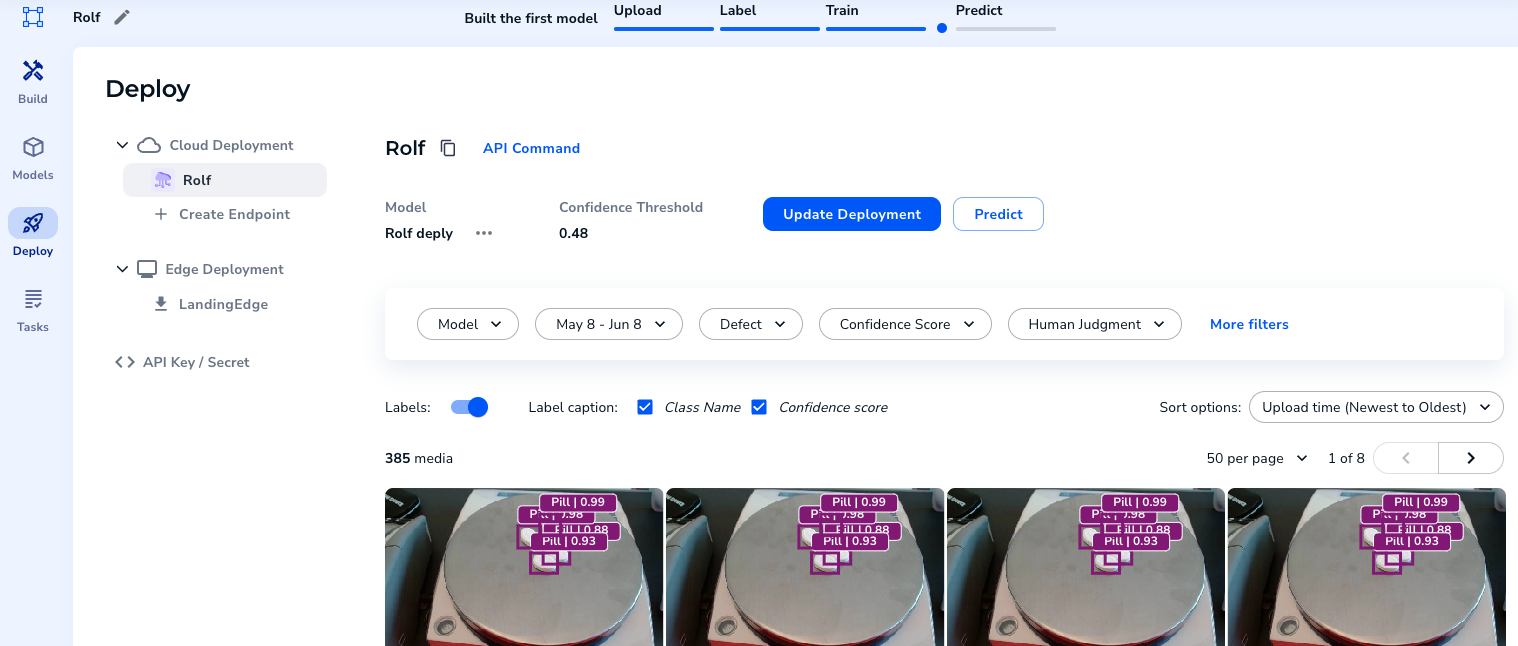

- 모델을 학습한 후에는 모델을 배포하고 엔드포인트를 만들 수 있습니다.

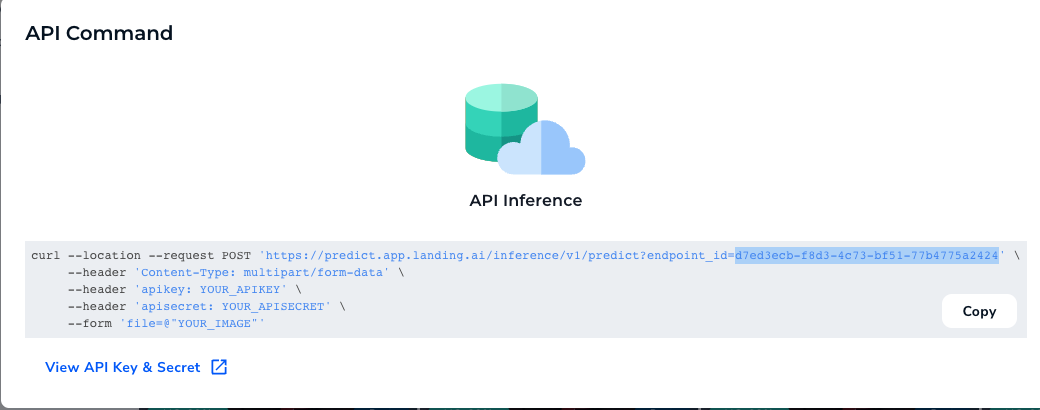

- "API 명령"을 선택하면 엔드포인트를 볼 수 있습니다

API 키와 비밀번호를 복사합니다.

작동 방식

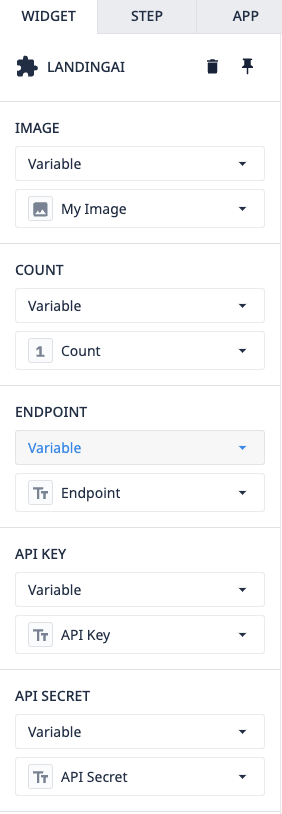

애플리케이션과 위젯 자체는 사용하기 쉽습니다. 위젯에는 미리 채워져 있는 몇 가지 소품이 있습니다.

이미지 - TulipCount - 위젯에 의해 쓰여지고 모델에서 감지된 오브젝트의 수를 나타내는 변수 엔드포인트 - 프로젝트에서 복사/붙여넣기된 변수API키 및 비밀 - 배포된 프로젝트에서 복사/붙여넣기된 변수입니다.

이 소품이 모두 채워지면 위젯은 LandingAI의 API에 요청을 보내고 오브젝트가 강조 표시된 이미지를 반환합니다.