Racionalizar el envío de datos de Tulip a Microsoft Fabric para ampliar las oportunidades de análisis

Propósito

Esta guía explica paso a paso cómo enviar datos de tablas Tulip a Fabric a través de una consulta API REST paginada. Esto es útil para analizar datos de tablas Tulip en Azure Data Lakehouse, Synapse Data Warehouse u otra ubicación de almacenamiento de datos Azure.

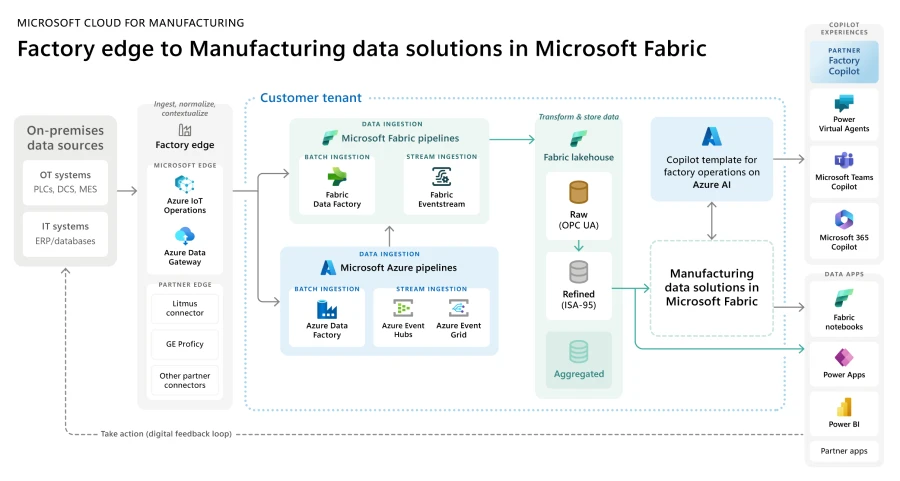

La arquitectura más amplia para Fabric -- Microsoft Cloud for Manufacturing se muestra a continuación

Configuración

A continuación se incluye un vídeo de configuración detallado:

Requisitos generales: * Uso de la API de Tulip Tables (obtenga la clave y el secreto de la API en la configuración de la cuenta) * Tulip Table (obtenga el ID único de la tabla)

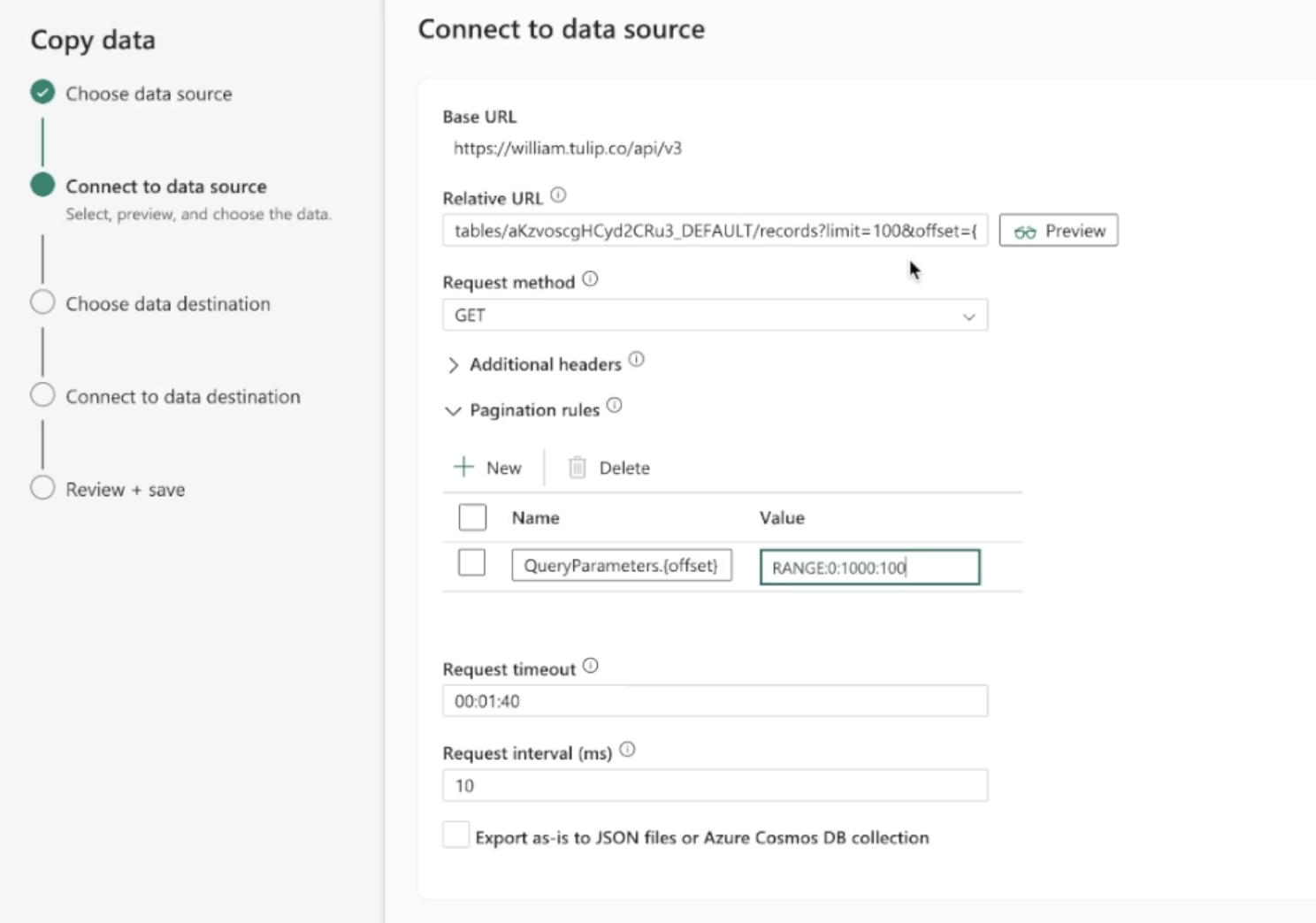

Proceso 1. En la página de inicio de Fabric, vaya a Data Factory. 2. Cree una nueva canalización de datos en Data Factory. 3. Comience con el "Asistente de copia de datos" para agilizar el proceso de creación. Detalles del asistente de copia de datos Fuente de datos: REST 2. URL de base: https://[instance].tulip.co/api/v3 3. Tipo de autenticación: No. Tipo de autenticación: Básica 4. Nombre de usuario: API Key de Tulip 5. Contraseña: API Secret de Tulip Contraseña: API Secret de Tulip 6. 6. URL relativa: tables/[TABLE_UNIQUE_ID]/records?limit=100&offset={offset} 7. URL relativa: tables/[TABLE_UNIQUE_ID]/records?limit=100&offset={offset} 7. Solicitud: GET 8. Nombre de la opción de paginación: QueryParameters.{offset} 9. Opción de paginación Valor de la opción de paginación: RANGE:0:10000:100

Nota:el límite puede ser inferior a 100 si es necesario, pero el incremento en la paginación tiene que coincidirNota: el valor de paginación para el rango tiene que ser mayor que el número de registros de la tabla

- A continuación, puede enviar estos datos a una variedad de destinos de datos como Azure Lakehouse

- Conéctese al destino de datos, revise los campos / cambie el nombre según sea necesario, y ¡listo!

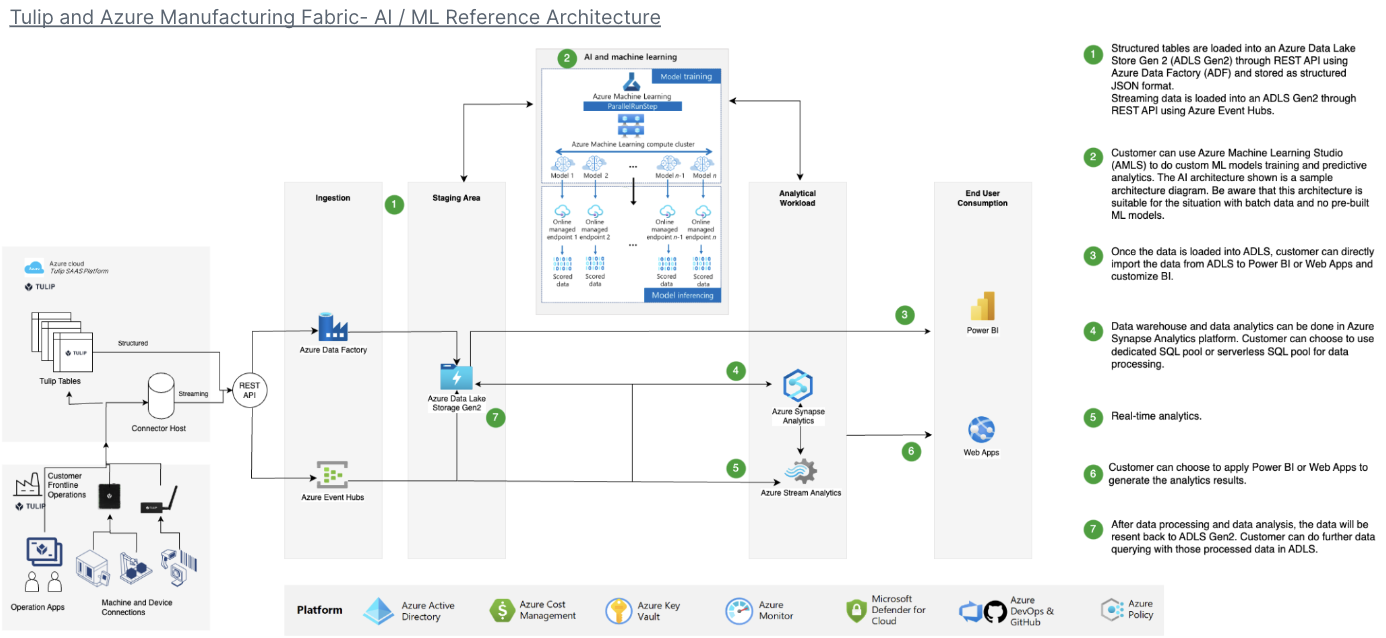

Ejemplo de arquitectura

Casos de uso y próximos pasos

Una vez que haya finalizado la conexión, puede analizar fácilmente los datos con un cuaderno de spark, PowerBI o una variedad de otras herramientas.

1. Predicción de defectos- Identifique los defectos de producción antes de que se produzcan y aumente el número de aciertos a la primera - Identifique los principales impulsores de la calidad en la producción con el fin de implementar mejoras.

2. Optimización del coste de lacalidad - Identificar oportunidades para optimizar el diseño del producto sin afectar a la satisfacción del cliente.

3. Optimizaciónde la energía de producción - Identificar palancas de producción para optimizar el consumo de energía

4. Predicción y optimización de la entrega y la planificación- Optimizar el programa de producción en función de la demanda del cliente y el programa de pedidos en tiempo real

5. Benchmarking global de máquinas / líneas- Benchmark de máquinas o equipos similares con normalización

**6. Gestión del rendimiento digital global /**regional Datos consolidados para crear cuadros de mando en tiempo real