- 印刷する

記事の要約

この要約は役に立ちましたか?

ご意見ありがとうございます

::: (info) () アプリのダウンロードはこちら:ライブラリ:::LandingAIのLandingLensを使用して、迅速な物体検出を実行します。

目的

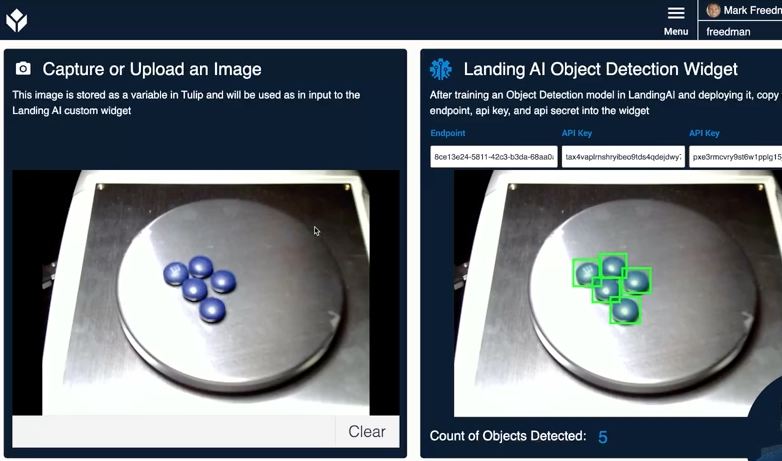

このウィジェットを使用すると、LandingLens内で作成したビジョン/機械学習モデルにアクセスできます。 このウィジェットを使用すると、Tulipで写真を撮影し、それをLandingLensのエンドポイントに送信して、AIモデルによって検出されたオブジェクトのカウントを返すことができます。

セットアップ

このウィジェットを使用するには、以下のアカウントが必要です。 https://landing.ai/{target="_blank"}. プラットフォームがどのように動作するかについての完全なドキュメントは、.LandingLensのサイトを参照してください。 support documentation

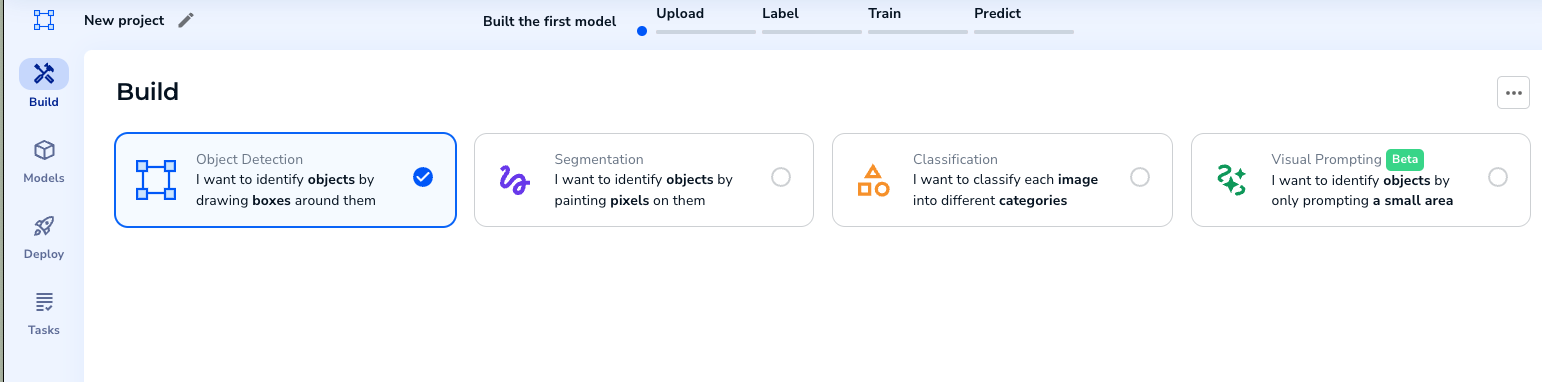

- 新しいプロジェクトを作成する。

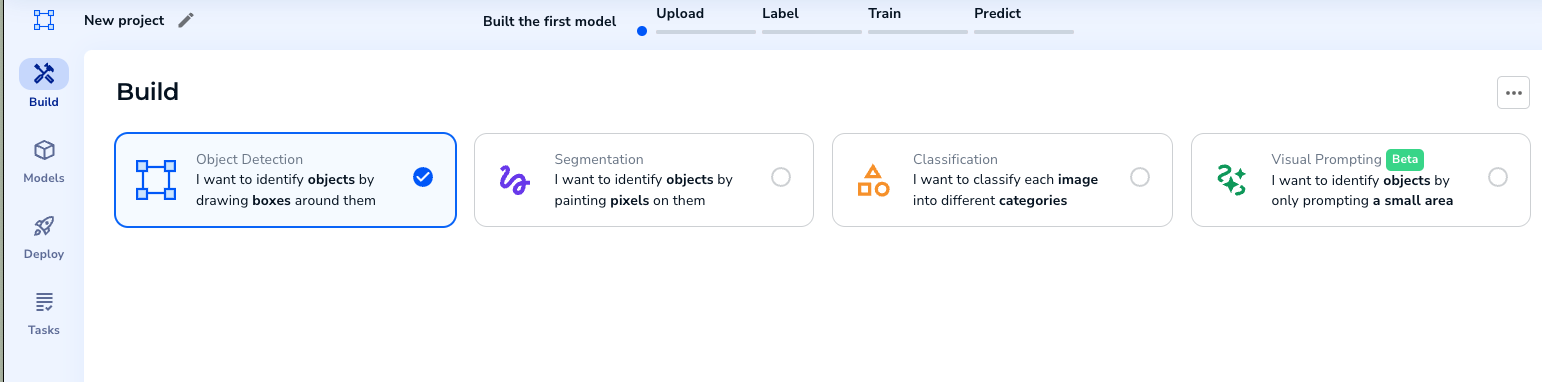

- オブジェクト検出プロジェクトを選択します。

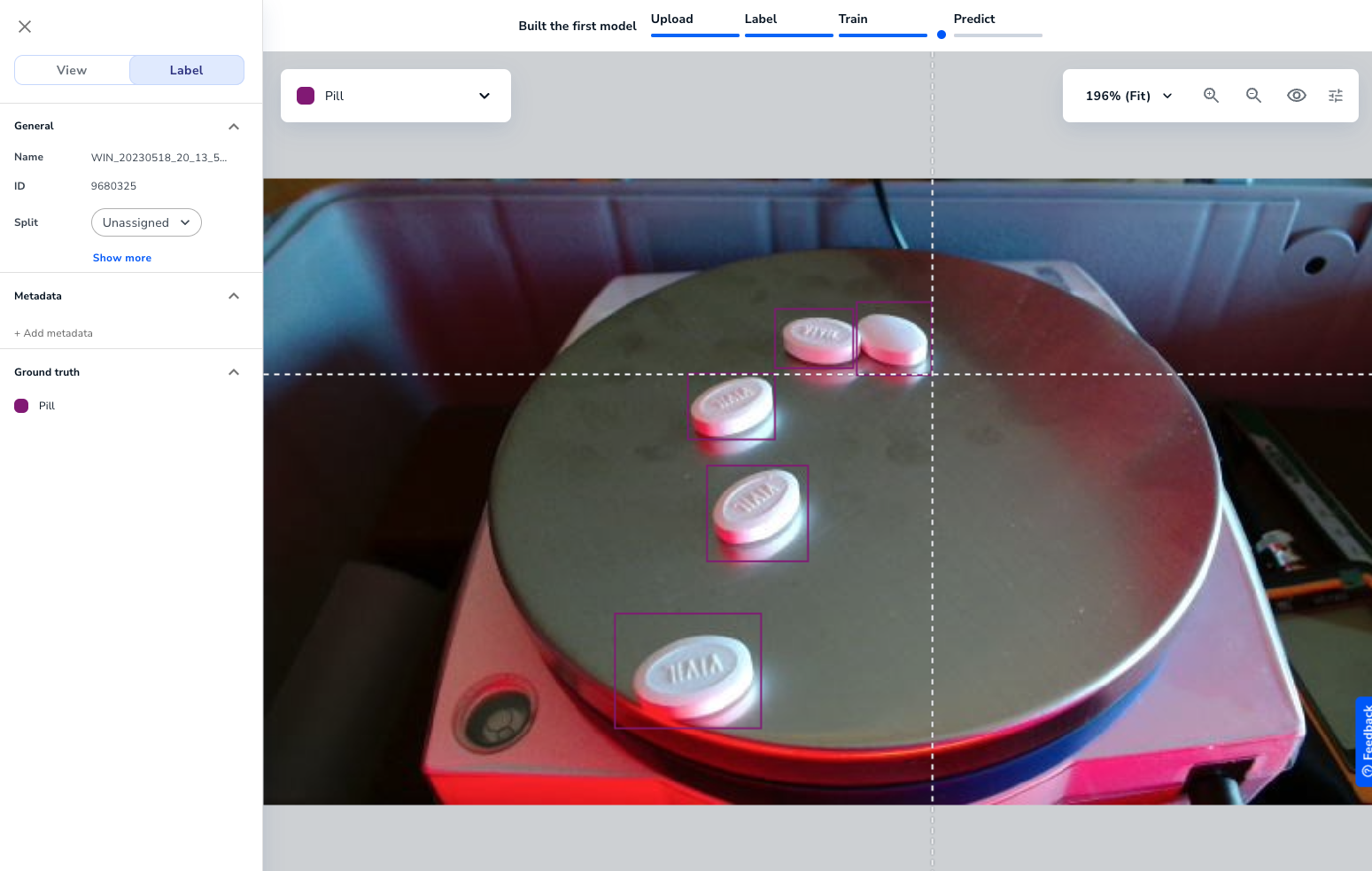

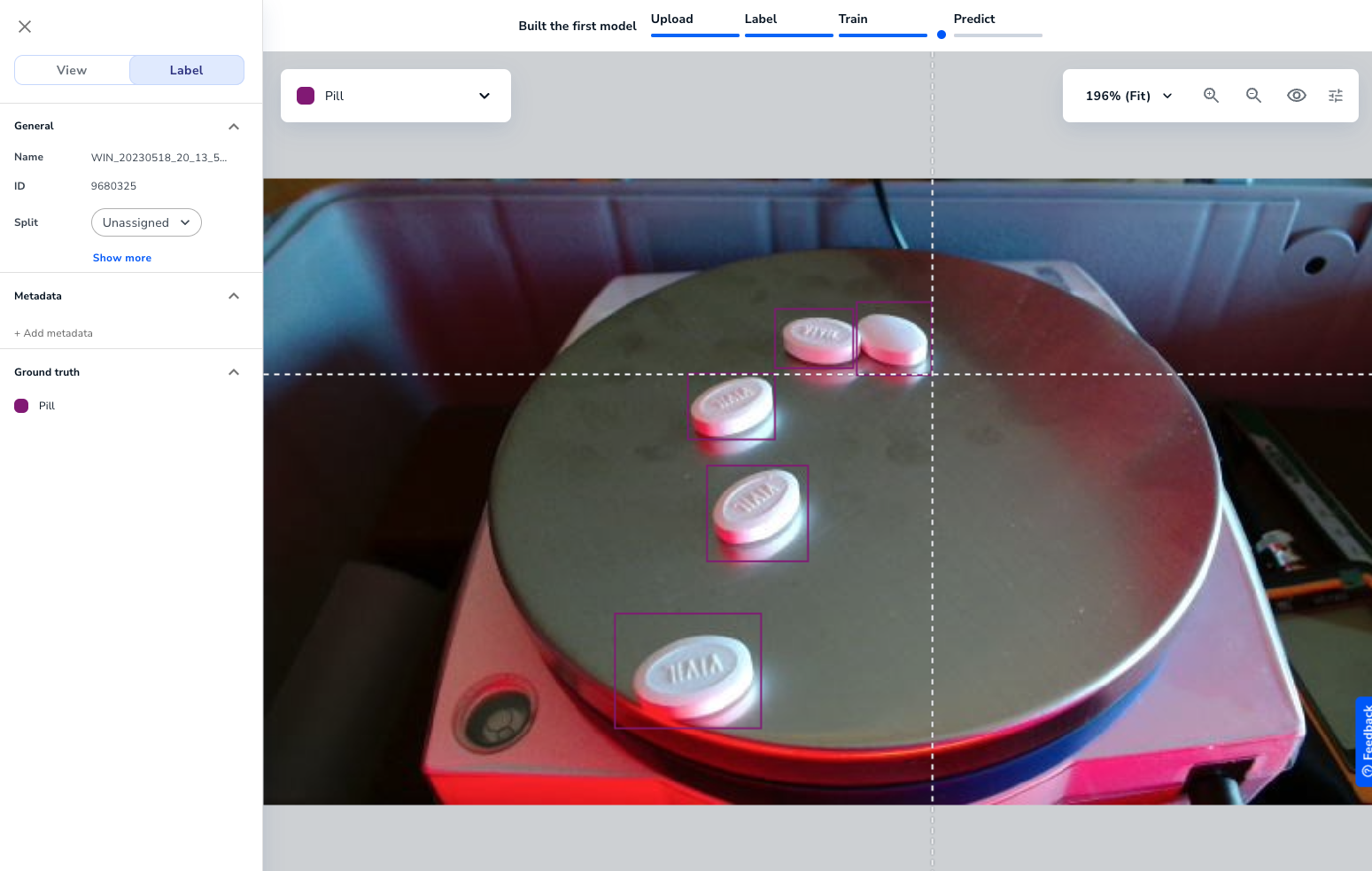

- トレーニング画像をアップロードします。 そして、画像にオブジェクトを識別するラベルをつけます。

十分な画像がラベル付けされたら、モデルをトレーニングすることができます。

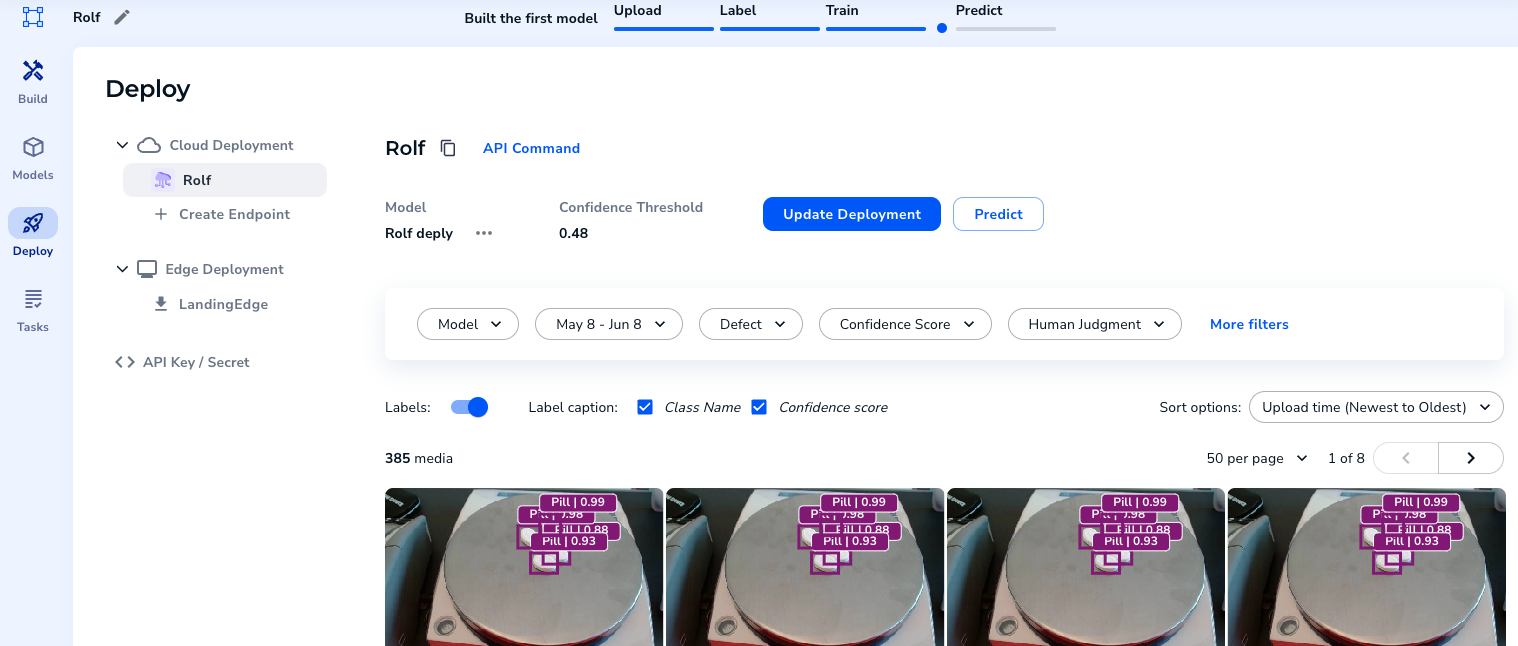

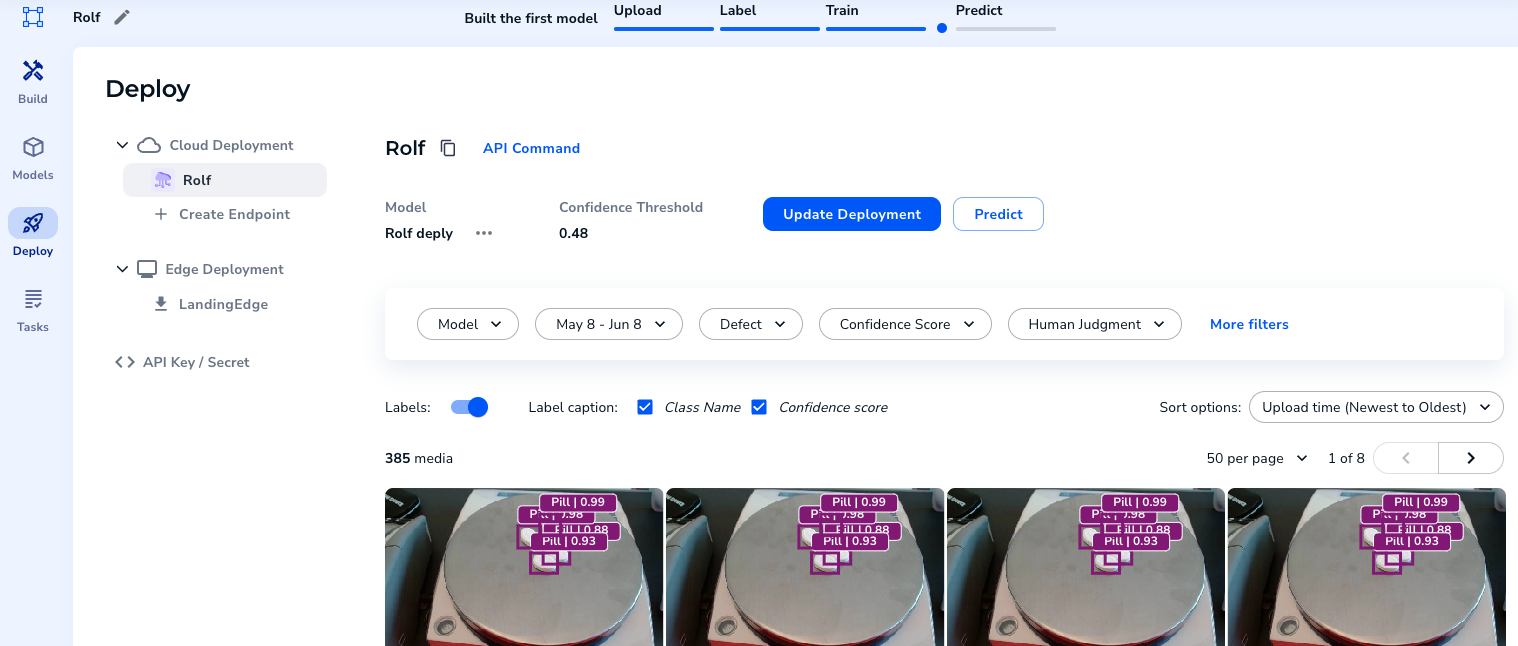

- モデルをトレーニングしたら、デプロイしてエンドポイントを作成します。

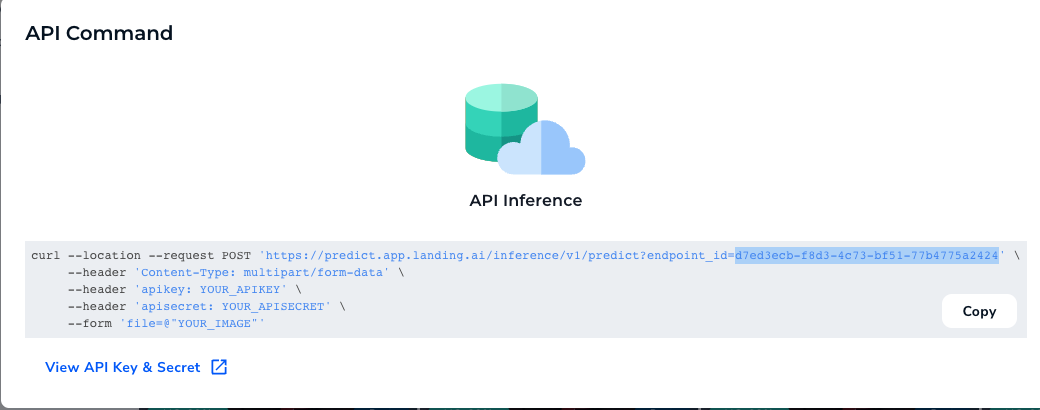

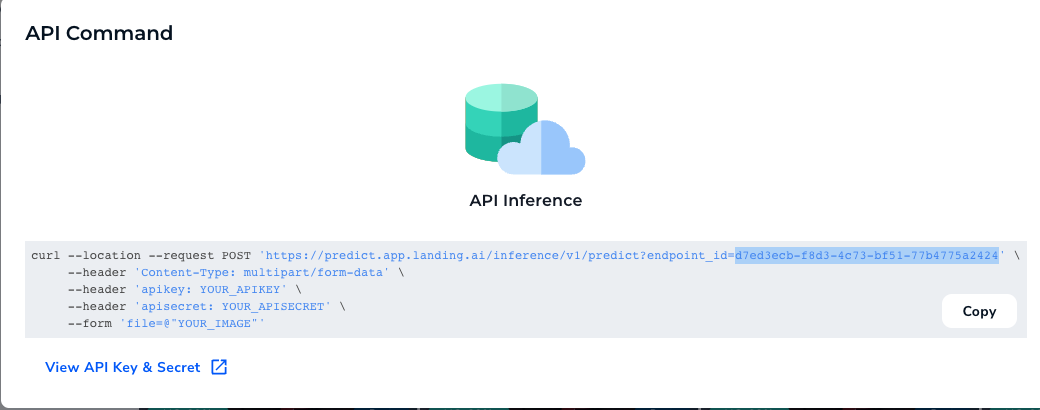

- API Command "を選択すると、エンドポイントが表示される。

APIキーとシークレットをコピーする。

どのように動作するか

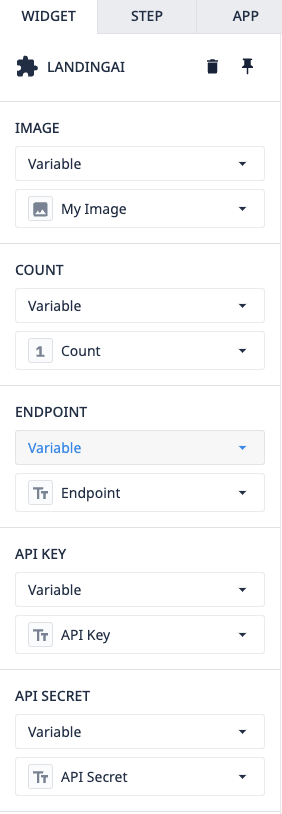

アプリケーションとウィジェット自体の使い方は簡単です。ウィジェットには、いくつかの小道具があらかじめ用意されています。

Image- Tulip から LandingLens に送信する画像ですCount- この変数はウィジェットによって書き込まれ、モデルによって検出されたオブジェクトの数を表しますEndpoint- プロジェクトからコピー/ペーストされたものですAPI Key & Secret- デプロイされたプロジェクトからコピー/ペーストされたものです。

これらのプロップがすべて入力されると、ウィジェットは LandingAI の API にリクエストを送信し、オブジェクトがハイライトされた画像を返します。

この記事は役に立ちましたか?